Часто задаваемые вопросы

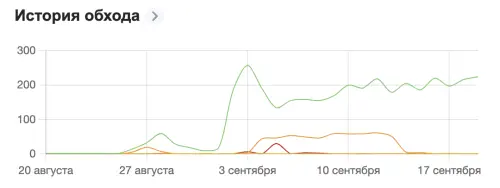

Поисковые роботы, также называемые веб-краулерами или пауками, играют ключевую роль в обнаружении нового контента для поисковых систем. Они автоматически сканируют веб, следуя по гиперссылкам от одной страницы к другой. Робот запускается с некоторых начальных страниц (часто главная страница сайта), затем рекурсивно переходит по всем ссылкам, которые находит на каждой странице.

При обнаружении новой или обновленной страницы робот передает ее URL и контент в центральную базу данных поисковой системы. Эта база данных затем используется для построения индекса, по которому происходит поиск. Роботы также могут сравнивать текущую версию страницы с предыдущими версиями, чтобы определить, были ли внесены какие-либо значительные изменения в контент.