Как улучшить структуру сайта для быстрой индексации

Часто задаваемые вопросы

-

1

Как улучшить структуру сайта для быстрой индексации?

Для ускоренной индексации сайта важно создать удобные для поисковых систем URL, использовать правильную внутреннюю перелинковку, обеспечить наличие актуальной карты сайта (sitemap) и правильно настроить файл robots.txt. Эти элементы помогают поисковым роботам быстрее и эффективнее находить и индексировать страницы вашего сайта.

-

2

Как URL-структура влияет на индексацию?

Чистые, краткие и логичные URL-адреса помогают поисковым системам лучше понимать структуру вашего сайта и быстрее находить важные страницы. Рекомендуется использовать URL, содержащие ключевые слова, и избегать длинных и сложных параметров.

-

3

Что такое карта сайта (sitemap) и как она помогает индексации?

Карта сайта (sitemap) — это XML-файл, который содержит ссылки на все важные страницы вашего сайта. Она помогает поисковым роботам быстрее находить новые и обновленные страницы для их индексации. Регулярное обновление sitemap и его отправка в поисковые системы через Google Search Console и Яндекс.Вебмастер ускоряет процесс индексации.

-

4

Как файл robots.txt влияет на индексацию сайта?

Файл robots.txt регулирует доступ поисковых роботов к страницам вашего сайта. Он позволяет указать, какие страницы можно индексировать, а какие — нет. Важно правильно настроить этот файл, чтобы не случайно заблокировать доступ к важным страницам, которые должны индексироваться.

-

5

Как ваш сервис помогает ускорить индексацию?

Наш сервис автоматизирует процесс индексации, отслеживая обновления на вашем сайте и отправляя новые страницы напрямую в поисковые системы через API. Это позволяет существенно сократить время, необходимое для индексации, и сделать ваш сайт видимым для поисковых систем значительно быстрее.

Структура сайта — один из ключевых факторов, влияющих на скорость и эффективность индексации страниц поисковыми системами. Чем проще и понятнее поисковым роботам ориентироваться на вашем сайте, тем быстрее новые страницы попадут в индекс и станут видимыми для пользователей. Рассмотрим основные элементы, которые помогут оптимизировать структуру сайта для быстрой индексации.

1. Удобные для поисковиков URL

URL должны быть короткими, понятными и отражать структуру контента на сайте. Это важно не только для пользователей, но и для поисковых систем, которые предпочтительно работают с логичной и иерархической структурой страниц. Вот несколько рекомендаций:

- Используйте чистые и понятные URL, избегайте параметров и длинных цепочек символов.

- Разделяйте слова в URL дефисами, чтобы поисковые системы могли правильно интерпретировать их.

- Следите, чтобы URL содержал ключевые слова, связанные с содержанием страницы, но не перегружайте его.

Пример хорошего URL: https://example.com/blog/kak-uluchshit-strukturu-saita

2. Внутренние ссылки

Внутренняя перелинковка помогает поисковым роботам быстрее находить новые страницы и понять их значимость. При грамотной внутренней структуре, роботы будут легко перемещаться по вашему сайту и индексировать страницы.

- Убедитесь, что важные страницы сайта имеют достаточное количество внутренних ссылок.

- Используйте анкорные тексты, которые точно описывают контент ссылок, что помогает поисковым системам лучше понимать структуру сайта.

- Не забывайте о хлебных крошках (breadcrumbs) — они упрощают навигацию как для пользователей, так и для поисковых роботов.

3. Карта сайта (Sitemap)

Карта сайта — это файл, который содержит ссылки на все важные страницы сайта и помогает поисковым роботам быстрее находить и индексировать новый контент. Sitemap должен быть регулярно обновляемым и включать ссылки на все страницы, которые вы хотите видеть в поисковых системах.

- Создайте XML-карту сайта, чтобы роботы могли легко находить новые и обновленные страницы.

- Убедитесь, что ваша карта сайта правильно настроена и отправлена в Google Search Console и Яндекс.Вебмастер.

4. Файл robots.txt

Файл robots.txt — это важный элемент, который указывает поисковым роботам, какие страницы можно индексировать, а какие — нет. При неправильной настройке файла robots.txt, важные страницы могут быть заблокированы для индексации.

- Убедитесь, что вы не блокируете важные страницы для индексации с помощью неправильных правил в

robots.txt. - Используйте директиву

AllowиDisallowс осторожностью, чтобы избежать случайной блокировки ключевого контента.

Пример настройки файла robots.txt: User-agent: * Disallow: /admin/ Allow: /blog/

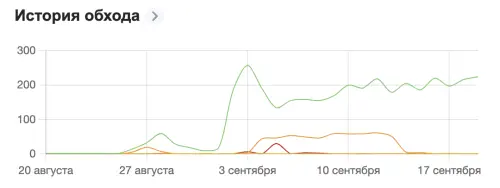

Как наш сервис помогает ускорить индексацию

Наша платформа автоматизирует процессы, связанные с индексацией, и дополняет ваши усилия по оптимизации структуры сайта:

- Автоматическое сканирование sitemap для поиска новых страниц и их отправки в поисковые системы.

- Отправка страниц через открытые и закрытые API в популярные поисковые системы (Google, Яндекс, Bing и другие), что помогает ускорить процесс их появления в результатах поиска.

Эти инструменты работают вместе с оптимизированной структурой вашего сайта, обеспечивая быструю и качественную индексацию контента.

Привет на связи indxr

Хочешь быть на передовой в мире SEO и контента? Присоединяйся к нам, будь то новичок или профи! Помогай делать сайты видимыми и создавай что-то реально значимое вместе с нами!

Недавние записи

Как правильно настроить метатеги для улучшения SEO и индексации сайта

Как попасть в поисковую выдачу: Полное руководство по индексации вашего сайта

Успешный кейс ускоренной индексации сайта Rankify.ru с использованием сервиса indxr.ru

Как улучшить структуру сайта для быстрой индексации

Что такое карта сайта и как она влияет на поиск?

Почему важно использовать W3C Validator

Использование AI и машинного обучения для автоматической оптимизации контента

Robots.txt: просто о сложном