Robots.txt: просто о сложном

Часто задаваемые вопросы

-

1

Что такое Robots.txt?

Robots.txt — это текстовый файл, который размещается в корневой директории вашего сайта и управляет доступом поисковых роботов к страницам сайта. Он позволяет указать, какие страницы должны быть проиндексированы поисковыми системами, а какие — нет.

-

2

Как работает файл Robots.txt?

Когда поисковый робот посещает ваш сайт, он сначала ищет файл robots.txt, чтобы понять, какие страницы ему разрешено сканировать. Файл содержит директивы, которые указывают, каким частям сайта доступен робот.

-

3

Почему правильная настройка Robots.txt важна?

Правильная настройка файла robots.txt помогает управлять тем, какие страницы вашего сайта будут доступны для индексации. Это важно для исключения из индексации страниц, которые не должны появляться в поисковых системах, таких как страницы входа или административные панели.

-

4

Какие ошибки могут возникнуть при настройке Robots.txt?

Одна из распространенных ошибок — это полное закрытие сайта от индексации через директиву Disallow: /. Это запретит поисковым роботам сканировать весь сайт. Также можно случайно закрыть от индексации важные страницы, что приведет к снижению видимости сайта в поисковых системах.

-

5

Как Indxr помогает управлять Robots.txt?

Indxr предлагает инструменты для мониторинга и настройки файла robots.txt. С его помощью можно проверить настройки файла, автоматически следить за его доступностью для поисковых роботов и получать рекомендации по оптимизации.

Файл robots.txt — это важный элемент любого сайта, который часто остаётся без должного внимания. Однако его правильная настройка может существенно повлиять на то, как поисковые системы видят и индексируют ваш сайт. В этой статье мы разберёмся, что такое robots.txt, как он работает и почему его настройка так важна для SEO. Также мы расскажем, как Indxr может помочь вам эффективно управлять этим файлом.

Что такое Robots.txt?

Robots.txt — это текстовый файл, который размещается в корневой директории вашего сайта. Он служит для управления доступом поисковых роботов к страницам вашего сайта. В этом файле можно указать, какие страницы и разделы сайта должны быть проиндексированы поисковыми системами, а какие — нет.

Как работает Robots.txt?

Когда поисковый робот, например, Googlebot, посещает ваш сайт, он первым делом ищет файл robots.txt, чтобы понять, какие страницы ему разрешено сканировать. Этот файл содержит набор правил, называемых директивами, которые указывают, каким частям сайта доступен робот.

Пример простого файла Robots.txt:

User-agent: *

Disallow: /private/

Allow: /- User-agent:

*— означает, что правило применяется ко всем поисковым роботам. - Disallow:

/private/— запрещает роботу доступ к разделу/private/. - Allow:

/— разрешает доступ ко всем остальным страницам сайта.

Руководство по директивам robots.txt

Описание: Определяет, к какому поисковому роботу применяется правило.

Пример использования: User-agent: Googlebot

Рекомендации: Указывайте конкретного робота, если нужно создать отдельные правила для разных поисковых систем.

Описание: Запрещает доступ к указанному разделу или странице.

Пример использования: Disallow: /private/

Рекомендации: Используйте для закрытия конфиденциальных разделов сайта (например, /admin/).

Описание: Разрешает доступ к указанному разделу или странице, несмотря на общие запреты.

Пример использования: Allow: /public/

Рекомендации: Используйте вместе с Disallow для разрешения доступа к отдельным страницам в запрещённых разделах.

Описание: Указывает путь к карте сайта (sitemap.xml), которая помогает поисковым системам индексировать сайт.

Пример использования: Sitemap: https://example.com/sitemap.xml

Рекомендации: Обязательно включите эту директиву, чтобы ускорить процесс индексации.

Описание: Задает задержку между запросами поискового робота к серверу, чтобы снизить нагрузку.

Пример использования: Crawl-delay: 10

Рекомендации: Рекомендуется для сайтов с ограниченными серверными ресурсами, чтобы предотвратить перегрузку.

Описание: Указывает предпочтительный домен для индексации, используется в некоторых поисковых системах.

Пример использования: Host: www.example.com

Рекомендации: Полезно для сайтов с несколькими зеркалами, чтобы указать основной домен.

Описание: Запрещает индексацию страницы, даже если доступ к ней разрешен.

Пример использования: Noindex: /no-index-page/

Рекомендации: Используйте осторожно, так как не все поисковые системы поддерживают эту директиву.

Описание: Шаблон, который позволяет указать директивы для всех страниц или типов файлов.

Пример использования: Disallow: /*.pdf$

Рекомендации: Используйте для запрета индексации всех файлов определенного типа, например, PDF-документов.

Описание: Указывает на конец URL, что позволяет более точно задать правило для страниц или файлов.

Пример использования: Disallow: /*.php$

Рекомендации: Используйте для закрытия от индексации всех страниц с определённым расширением.

Почему правильная настройка Robots.txt важна?

Правильная настройка файла robots.txt помогает вам управлять тем, какие страницы вашего сайта будут доступны для индексации. Это особенно важно для страниц, которые не должны появляться в результатах поиска, таких как страницы входа, корзины покупок или административные панели.

Потенциальные ошибки в Robots.txt

- Полное закрытие сайта от индексации: Если вы случайно добавите строку

Disallow: /, это запретит поисковым роботам сканировать ваш сайт полностью. - Закрытие важного контента: Неправильная настройка может привести к тому, что важные страницы, такие как статьи или страницы продуктов, не будут проиндексированы.

Как Indxr помогает управлять Robots.txt?

Indxr предлагает инструменты для мониторинга и настройки файла robots.txt. С помощью нашего сервиса вы можете:

- Проверить настройки Robots.txt: Indxr поможет вам убедиться, что файл настроен правильно и не содержит ошибок, которые могут повлиять на индексацию.

- Автоматически проверять доступность: Indxr регулярно проверяет, доступен ли файл

robots.txtдля поисковых роботов и соответствует ли он лучшим практикам. - Получать рекомендации: Indxr предлагает полезные советы по оптимизации файла

robots.txt, чтобы улучшить видимость вашего сайта в поисковых системах.

Файл robots.txt — это мощный инструмент управления индексацией вашего сайта. Правильная настройка этого файла помогает поисковым системам правильно сканировать и индексировать ваш сайт, исключая нежелательные страницы. Использование сервиса Indxr поможет вам избежать ошибок и убедиться, что ваш файл robots.txt настроен оптимально. Это важно для улучшения видимости вашего сайта и достижения высоких позиций в поисковых системах.

Привет на связи indxr

Хочешь быть на передовой в мире SEO и контента? Присоединяйся к нам, будь то новичок или профи! Помогай делать сайты видимыми и создавай что-то реально значимое вместе с нами!

Недавние записи

Как правильно настроить метатеги для улучшения SEO и индексации сайта

Как попасть в поисковую выдачу: Полное руководство по индексации вашего сайта

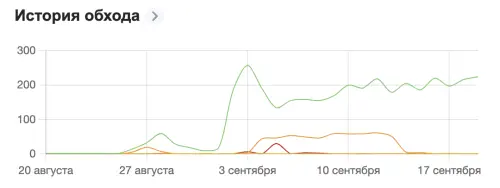

Успешный кейс ускоренной индексации сайта Rankify.ru с использованием сервиса indxr.ru

Как улучшить структуру сайта для быстрой индексации

Что такое карта сайта и как она влияет на поиск?

Почему важно использовать W3C Validator

Использование AI и машинного обучения для автоматической оптимизации контента

Robots.txt: просто о сложном